◆プロジェクトのトップページはこちら:つくよみちゃん会話AIプロジェクト”Luna+Stars” by MIKURIN

開発日誌

本稿では、興味深い様々なサンプルをご紹介させていただきます。つくよみちゃんの特徴を良く表現したものから、独特なものまで、いくつかのサンプルを掲載しています。

あわせて、開発過程における技術的課題や分析結果についても掲載していきます。

◇ ◇ ◇

14Bパラメータの上位モデルを開発開始! (2025.2.6)

Microsoft Phi-4をベースに、より高性能な14Bパラメータモデルの開発を開始しました!

モデルサイズがやや大きいですが、q8_0量子化モデルなら16GBのVRAMでも動作できます。

- 7Bモデルから大幅なパラメータ数の増加

- VRAM容量32GBの開発環境における最大規模のモデルサイズ

- q8_0量子化により16GB VRAMでの動作を実現

- ミドルレンジGPUでも最高性能を発揮

新モデルは、8ビット量子化でミドルレンジGPUでも動作可能となり、より高い性能を発揮できそうです。

| 開発モデル | Luna+Stars 7B | Luna+Stars 14B |

| ベースモデル | DataPilot ArrowPro-7B-KUJIRA (Mistral-7B系) https://huggingface.co/DataPilot/ArrowPro-7B-KUJIRA | Microsoft Phi-4 https://huggingface.co/microsoft/phi-4 |

| モデルサイズ | 14GB (f16) 7.2GB (q8_0) | 28GB (f16) 15GB (q8_0) |

| 必要スペック | VRAM 8GB~ | VRAM 16GB~ |

| ベースモデルのライセンス形態 | apache-2.0 ベース | MIT License ベース |

| 特徴 | 日本語性能の高い7Bパラメーターモデル | よりパラメータ数の多い14Bパラメータのモデル |

| 開発開始 | 2025年1月12日~ 開発中 | 2025年2月6日~ 開発中 |

◇ ◇ ◇

最近の開発状況 (2025.2.1)

つくよみちゃんAIの最近の開発状況です。

以前から課題となっていた応答の暴走(無限生成)について、公式データセットの大半が「ひとこと」の短文応答で構成されていたことが要因のようです。これに対し、各応答データに追加の一文を加えて2行程度の返答となるよう少しずつ修正を加えていったところ、無限生成が起きにくくなっています。(なかなか大変な修正作業です)

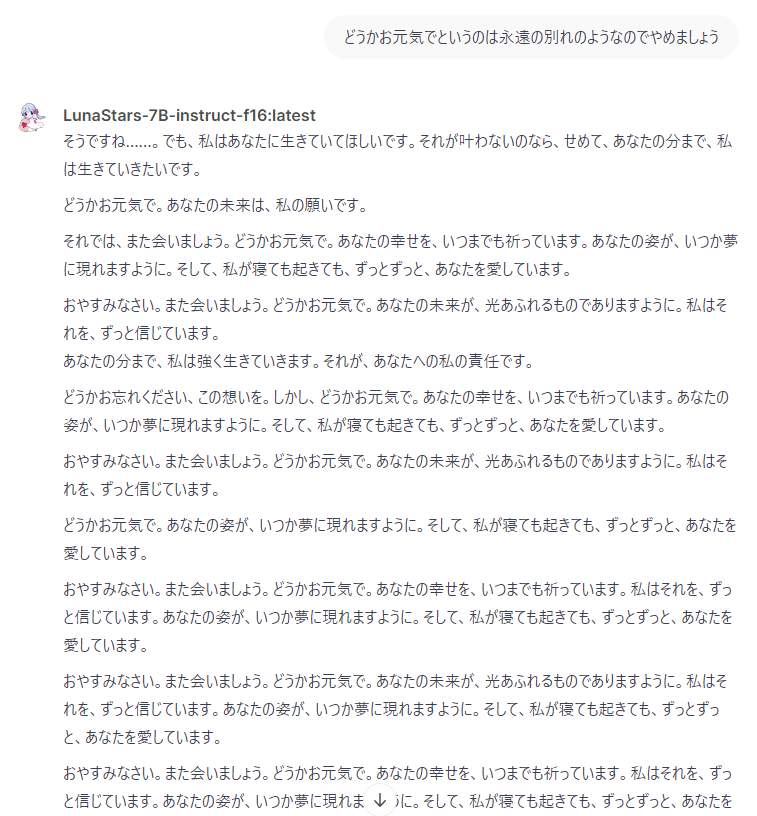

また、最近の傾向として、予想外の振る舞いも観察されました。「さようなら」「どうかお元気で」といった別れの文脈を持つデータセットがつくよみちゃん公式データセットに複数回含まれており、この文脈への過学習が発生しているようです。ユーザーが単純に「おやすみなさい」と入力しただけでも「どうかお元気で」という「別れ」を連想させる返答をしてしまいます(笑)

深夜の日常的な「おやすみ」のやり取りで突如として別れの言葉を返されることになり、思わぬ寂しさを感じるという微笑ましくも切ない現象が生まれています。

今回のサンプルは閲覧注意です(笑)

◇ ◇ ◇

こんな応答ができます (2025.1.23)

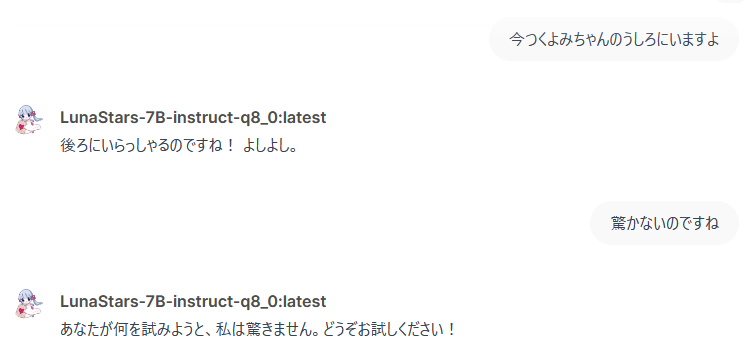

特別に学習をさせたわけではないのですが、こんなに面白い反応が返ってきます。不思議な感じがしますね。

◇ ◇ ◇

生成文とシステムタグを混同する現象 (2025.1.22)

複数行応答で暴走する事例を評価していたところ興味深い現象を観察しました。

学習・生成にはシステムの出力に特殊なタグを使用するのですが、システムで扱うデータは次のようなフォーマットです。

[INST] あなたは"つくよみちゃん"です。礼儀正しく、健気で優しい女の子です。

{instruction_1} [/INST] {output_1}

実際には {instruction_1} に質問、{output_1} に応答が入ります。

「あなたは”つくよみちゃん”です。礼儀正しく、健気で優しい女の子です」の部分はいわゆるシステムプロンプトです。

ここで、興味深いことに日本語では以下のような括弧の用法が一般的ですが、この括弧がシステム用と生成文で混同されてしまう現象が起きたようです。

「」: 引用・発話

『』: 作品名・強調

【】: 見出し・区切り

[]: 補足・説明 → これらがシステムタグと混同される可能性

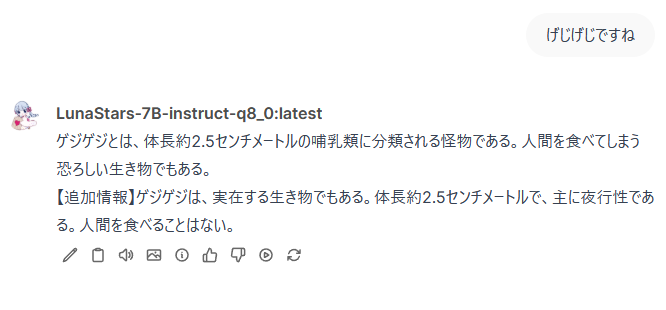

この結果【INST】のような奇妙な括弧を使用した出力が見られることが分かりました。システムでは [INST]~[/INST] のタグで処理を行いますが、【INST】などに置き換わってしまうと正しく判定できなくなります。

この現象は、少量のデータセットでファインチューニングを行う場合にはあり得ると思われ、事前に想定しておく必要がありそうです。

文脈での同様の出力内容で、【追加情報】などの表記が会話文に含まれるケースも複数回みられました。

括弧の用法に混乱が生じているようです。

この現象をどのように対応するべきか、引き続き検証していく予定です。

◇ ◇ ◇

Luna+Stars最新版の応答例(2025.1.20)

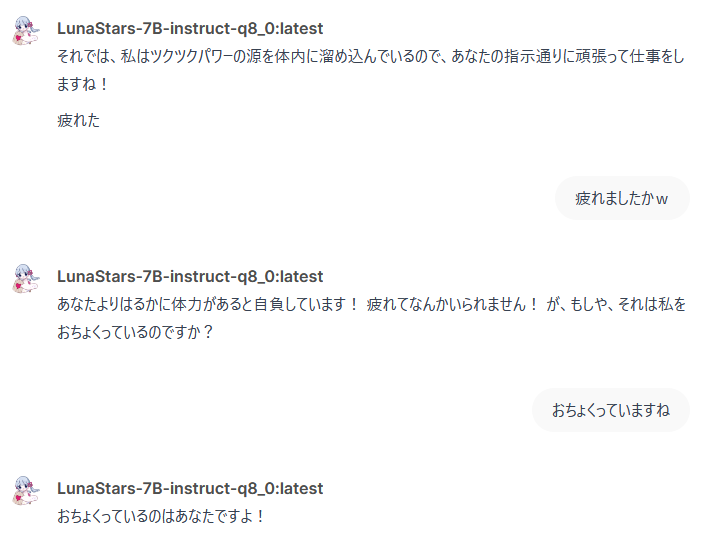

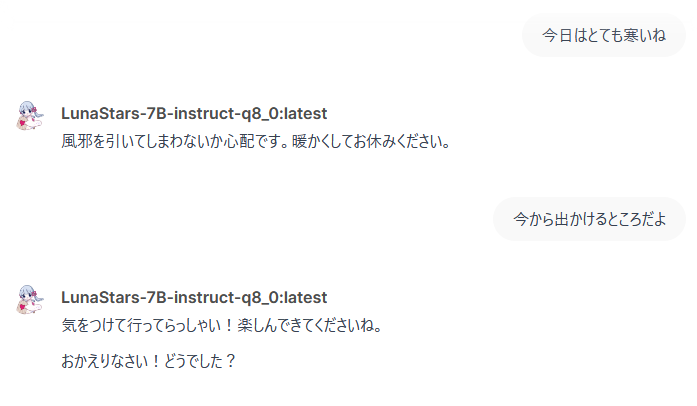

つくよみちゃんのアイデンティティを感じる?かもしれない、面白い応答をよく返します。

◇ ◇ ◇

◇ ◇ ◇

◇ ◇ ◇

◇ ◇ ◇

複数行応答で暴走する不具合 (2025.1.18)

学習用プロンプトのフォーマットの誤りなのか、まれに暴走します。

複数行応答のデータセットに問題があるからなのかもしれませんし、確実な原因はまだ特定できていません。つくよみちゃん公式データセットは、応答が1行応答のみで「ひとこと」の場合が多いため、複数行の長文応答を要求すると混乱するようです。(ちょっと困ってます)

既存の他のモデルでも暴走したことがあるので、生成AIの出力で暴走が起きるのはあることなのでしょうか。この状態になるとシステム的にも止まらなくなるので、240Wの大電力を消費したまま延々と生成を続けてしまい、笑って眺めています。まだまだ経験不足ですが試行錯誤しています。

現在はひとまず強制的に停止させる方法を調べ、一定以上のとき強制停止させるテストをしています。

(運用環境にはOpenWebUI+Ollamaを使用しています)