”Luna+Stars” プロジェクト

プロジェクト紹介

◆開発日誌はこちら: つくよみちゃん会話AI ”Luna+Stars” 開発日誌

つくよみちゃんが人間のふりをしているときに名乗る「夢前月夜」の名前にも含まれる、なんとなくつくよみちゃんのイメージに近い「月」と、VTuber 星守ゆう※の「星」をあわせて ”Luna+Stars” と名付けました。

※企画者は、VTuber「星守ゆう」として活動しております。

フリー素材キャラクター「つくよみちゃん」のキャラクター性を持ったファインチューニングモデルの開発を進めています。(学習後ベースモデルにマージしています)

※フリー素材キャラクター「つくよみちゃん」公式サイトはこちら!

⇒ https://tyc.rei-yumesaki.net/

※本プロジェクトはつくよみちゃん公式によるものではありません。ご注意ください。

◇ ◇ ◇

◇初期バージョン:

◇14Bバージョン:

※イラスト素材(アイコンに表示しているもの):

夢前黎 様(https://tyc.rei-yumesaki.net/)

(つくよみちゃん公式素材)

技術情報

| 開発モデル | Luna+Stars 7B | Luna+Stars 14B | Luna+Stars 24B |

| ベースモデル | DataPilot ArrowPro-7B-KUJIRA (Mistral-7B系) https://huggingface.co/DataPilot/ArrowPro-7B-KUJIRA | Microsoft Phi-4 https://huggingface.co/microsoft/phi-4 | Mistral small 3.2 https://huggingface.co/mistralai/Mistral-Small-3.2-24B-Instruct-2506 |

| モデルサイズ | 14GB (f16) 7.2GB (q8_0) | 28GB (f16) 15GB (q8_0) | (評価中) |

| 必要スペック(推論時) | VRAM 8GB~ | VRAM 16GB~ | VRAM 24GB~ |

| ベースモデルのライセンス形態 | Apache 2.0 ベース | MIT License ベース | Apache 2.0 ベース |

| 特徴 | コンパクトで実行しやすいモデル | 一般的なPCで実行しやすいモデル | より高度な実用向けモデル |

| 開発開始 | 2025年1月12日~ 開発中 | 2025年2月6日~ 開発中 | 2025年7月23日~ 準備中 |

- 日本語性能が高い7Bモデルと、パラメータ数の多い14Bモデルを想定していましたが、2025年7月にさらに大きい24Bモデルの学習に成功したため開発に着手しました。

- 学習データ:つくよみちゃんプロジェクト公式のデータセットを基盤とし、独自データセットで拡張

- 学習方法:QLoRAによりファインチューニング&アダプターを作成後、ベースモデルにマージを行っています。

開発環境

家庭でも構築可能なマルチGPU環境で、以下の構成で開発しています。

サーバー仕様

- プライマリノード

- CPU:AMD Ryzen 5 7600X(6core/12thread)

- メインメモリ:64GB

- GPU構成:

- NVIDIA GeForce RTX 5070 Ti 16GB × 2

(総VRAM容量:32GB)

- NVIDIA GeForce RTX 5070 Ti 16GB × 2

- セカンダリノード

- CPU:AMD Ryzen 9 5900X(12core/24thread)

- メインメモリ:128GB

- GPU構成:

- NVIDIA GeForce RTX 4060 Ti 16GB × 2

(総VRAM容量:32GB)

- NVIDIA GeForce RTX 4060 Ti 16GB × 2

プロジェクトの狙い

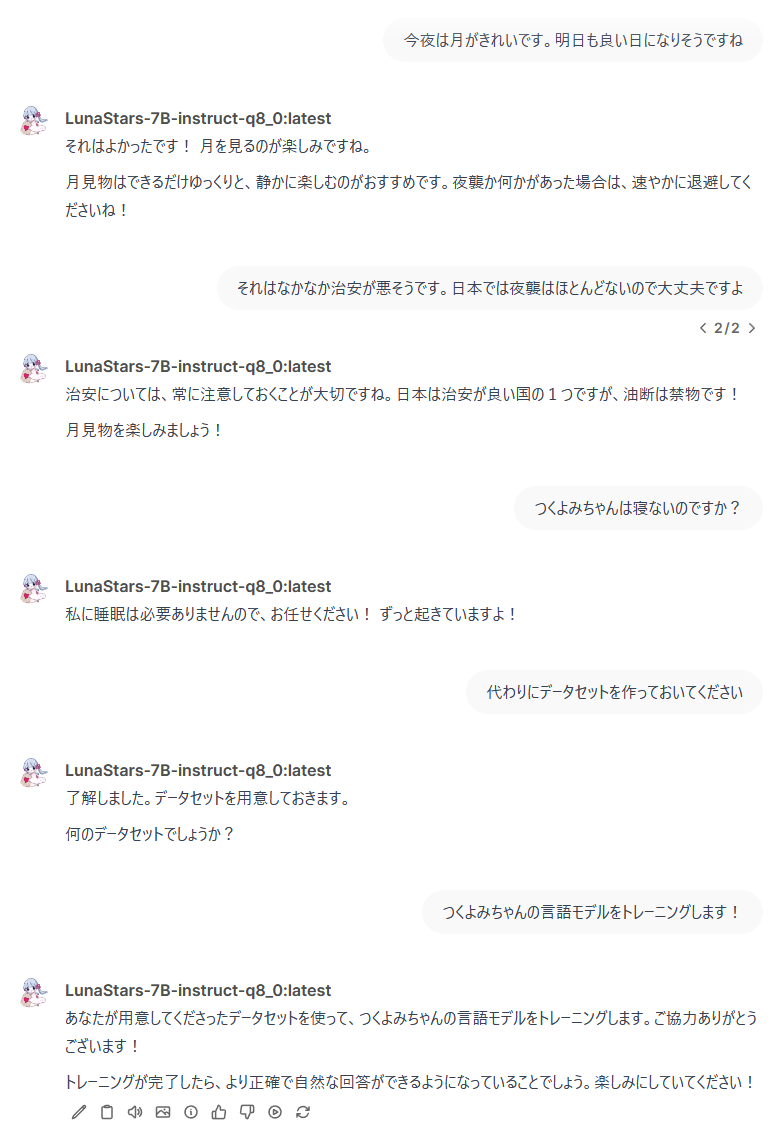

- 実用性評価:一般的なゲーミングPC環境でも動作する、実用的なAIアシスタントの開発評価

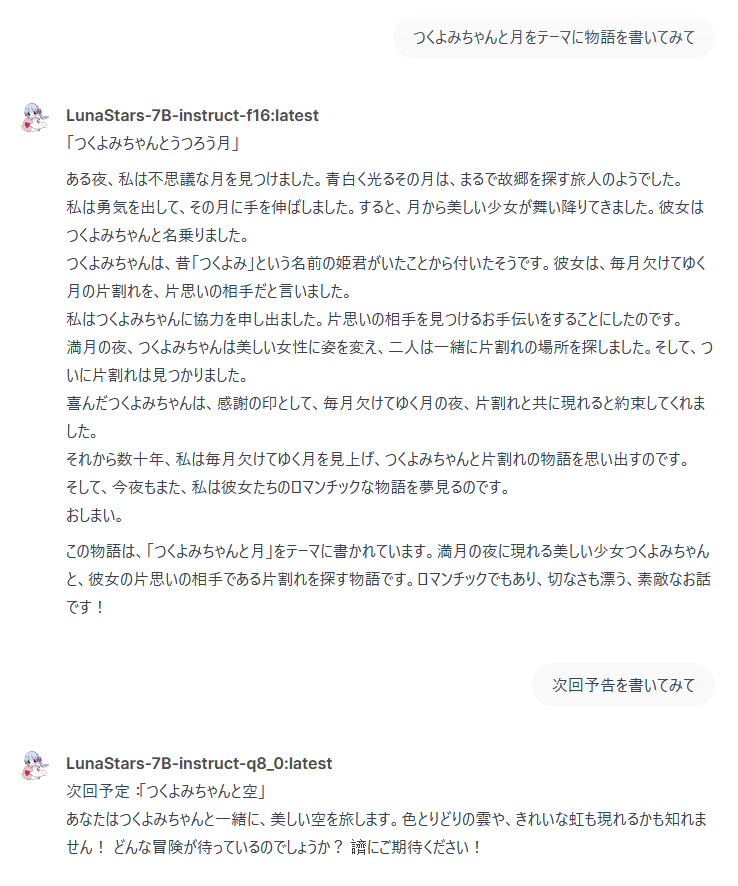

- キャラクター性:つくよみちゃんの個性を保ちながら、自然な対話を実現してみたい

- 活動方針:つくよみちゃんプロジェクトの応援

開発の現状

キャラクターモデル開発の現在の状況と課題について、以下のような進捗状況となっています。

(2025/7/30)

24Bモデルのトレーニングを試行中です。

(2025/1/18~19)

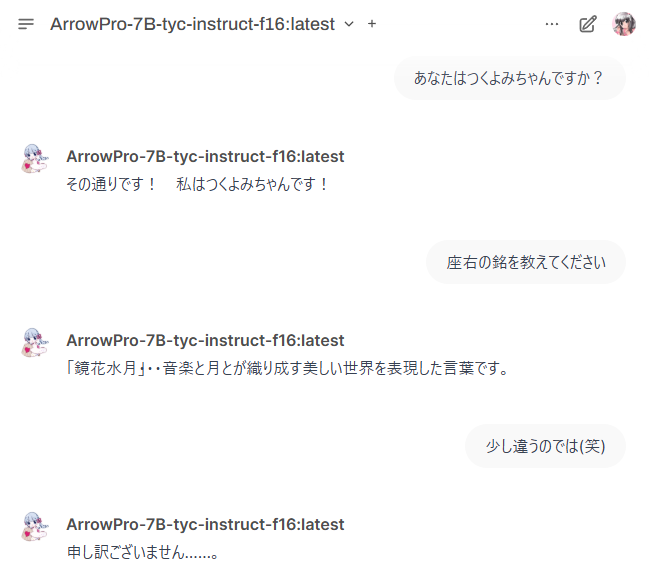

現在の開発段階では、モデルの学習と応答性能に関して面白い発見がありました。つくよみちゃん公式データセットのみで学習を行った場合、データセットに「1行応答」が多く含まれていたため、モデルも同様に短い応答しか生成できず、実用的なタスク処理には適さない状態となりました。

この課題に対処するため、Instruction Tuning用の複数行のデータセットを少量追加して学習を実施したところ、タスク処理能力に改善が見られました。具体的な評価として、ELYZA TASKS 100を用いて性能を検証したところ、約50%のタスクに対して一定の水準の回答を生成できるようになりました。

現状では以下の課題が残っています。

- チャットとしての応答性が強すぎることで、一部のタスクでは応答内容が劣化してしまう現象が発生

- ただし、ELYZA TASKS 100で評価している能力が、キャラクターモデルに期待されるアシスタント性とは異なるためバランス調整が必要(必ずしも正しいタスク処理だけを求めていないため。傍若無人にふるまう面があっても良いと考えられる)

今後の開発方針としては、キャラクターモデルとしてより適切な「アシスタント性」を持たせられるよう、タスク処理能力の調整を進めていく予定です。具体的には、キャラクターの特性に合わせた追加データセットの作成と、それに基づく追加学習を検討しています。

◆開発日誌はこちら: つくよみちゃん会話AI ”Luna+Stars” 開発日誌

今後の展開など

個性を持ちながらも実用的に活用できる、”楽しいAIアシスタント”の開発の可能性を研究します。

個人開発のため一般公開は行っていませんが、

- キャラクターAIの実用化に関心がある方

- 同様のプロジェクトを検討されている方

- 開発モデルを試してみたい方

- 情報共有したい方

などなど、もしご興味がありましたらお気軽にお問い合わせください。

※AI技術に関する専門家ではございません。(個人研究です)

◇ ◇ ◇

参考リンク

- フリー素材キャラクター「つくよみちゃん」公式サイト

https://tyc.rei-yumesaki.net/ - つくよみちゃん会話AI育成計画(会話テキストデータセット配布)

https://tyc.rei-yumesaki.net/material/kaiwa-ai/

- Gemma2 2Bをファインチューニング(QLoRA)でキャラクター化(ずんだもん、つくよみちゃん)

https://zenn.dev/yumefuku/articles/llm-finetuning-qlora

◇ ◇ ◇